本帖最后由 鹿鹿鹿 于 2025-5-5 18:11 编辑

作者|疯哥技术|疯聊教程|《掌握n8n,开启AI自动化之旅》 引言:当企业遇见AI自动化,你的企业和工作方式将被彻底改变,疯哥AI转型系列教程《掌握n8n,开启AI自动化之旅》教你如何从ChatGPT到Deepseek使用n8n+AI全面接手你的业务工作。本篇案例又在上篇案例的基础上做了大的升级,核心🈶两大技术点,一个是调用FLUX生成图片,另外一个是教你如何将RSS新闻与图片合并生成海报,并通过邮箱附件发送给用户。 )(加疯哥 worshipsme 拿案例源码)

)(加疯哥 worshipsme 拿案例源码) ** 我做了一个很有意思的“用户运营”AI自动化工作流 ** 上篇技术点回顾 ** 上篇教程(第六章)中讲解的技能点回顾: 1. AI代理:支持哪些AI大模型。 2. 工作流启动:触发器( Trigger )的种类,各自的作用。 3. 数据编辑:字段编辑( Edit Fields )节点。 4. 数据拆分:数据结构拆分( Split Out )节点。 5. 数据保存:数据库( Mongodb )节点。 6. 发送邮件:发送邮件( Send Email )节点。 7. 工作流执行:启动、和激活以及检查执行记录( Executions )。 8. 工作流权限:复制、下载、删除。 ** 本篇知识点** 本章你将学到的技能: 1. 获取新闻源:如何使用RSS节点获取最新内容。 2. 合并新闻源:合并数据( Merge )节点将多RSS数据合并到一起。 3. AI生成图片:调用FLUX大模型API生成图片 。 4. 判断执行状态:判断选择( Switch )节点,根据AI执行状态进一步做选择。 5. 下载图片文:数据库( Mongodb )节点,自动下载生成好的图片。 6. 图文合并:编辑图片( Edit Image )节点,文字和图片结合生成海报。 7. 发送带附件邮件:发送邮件( Send Mail )节点,邮件添加附件。 ** 本篇案例执行视频** 废话不多,请上我们今天的主角:“多RSS新闻聚合 + Deepseek分析新闻 + FLUX生成图片 + 定时发邮件【带附件】”,疯哥将录制的效果视频放在了本文的开头。我们以下截图,直接打开邮件查看内容,海报图片在附件中: 海报图片在邮件的附件中 点开附件new.jpg海报图片: 这是本章节案例整个AI自动化工作流的全流程截图,执行顺序是从左到右: 疯哥把前后两套A I自动化工作流截图放在一起做个对比,主要区别是本章工作流多了AI自动文生图和文字图片合并编辑的环节流程。 上图是无海报AI工作流,下图是带海报生成AI工作流: ** 多个RSS获取资讯新闻** 本篇的AI自动化工作流从调用RSS“阅读器”(RSS Read ( 阅读器 )节点)开始,通过RSS我们能非常方便的可以获取到多个媒体网站的最新资讯文章,疯哥先科普一下RSS是什么? RSS 的全称是"简易内容聚合"(Really Simple Syndication),是一个能让我们在一个网站订阅各种感兴趣内容的工具。 一个媒体网站支持 RSS,就意味着每当它新发布一篇新文章,就会往一个位于特定网址的文件中,以特定的语法(具体而言是 XML 标记语言或 JSON)增加一条记录,包括这篇文章的标题、作者、发表时间和内容(可以是全文,也可以是摘要)等信息。这样,我们只要搜集所有感兴趣的网站提供的这种文件的网址,并不时检查这些文件内容的更新,就能知道这些网站是否、何时发布了什么内容。RSS 阅读器的核心功能,就是存储用户订阅的 RSS 地址,以固定的频率自动检查更新,并将其内容转换为易读的格式呈现给用户。 举个例子,当我关注的某个人在知乎、或者在博客上回答了一个问题、写了一篇新文章,我马上就能收到推送。当我关注的人变多了,我不必一一点开知乎、简书、甚至翻看博客去主动获取更新,而是在一个统一的终端内阅读就可以了。 n8n提供完整高效稳定的 RSS Read ( 阅读器 )节点,我们可以从多个 RSS Read 节点 分别获取各自最新文章,然后进行汇总,再一条条让 Deepseek 分析总结,最后将结果以邮件形式发送给每一位需要的用户。 n8n提供的 RSS Read ( 阅读器 )节点,本例工作流中使用了多个 RSS Read,如下图: 设置RSS RSS Read ( 阅读器 )节点是 n8n 的一个内部(官方)节点,作用是从指定的 RSS 地址获取资讯文章。这不是一个 触发节点(Trigger) 节点,所以RSS Read ( 阅读器 )节点不会在媒体网站更新文章的时候自动触发AI自动化工作流。 如果希望网站更新文章的时候自动触发工作流的话,我们就应该使用 RSS Trigger (RSS触发)节点,会在 RSS 网站更新后会自动触发工作流。 这两个节点的区别 RSS Read ( 阅读器 )节点:不会触发工作流,每次调用是获取RSS全部文章。 RSS Trigger ( RSS触发 )节点:会触发工作流,每次调用只获取最新的文章。 我们需要根据实际情况选择用哪个 RSS节点,疯哥在本例中选择的是 RSS Read 因为要在每日指定时间触发工作流获取最新文章。 使用RSS Trigger ( RSS触发 )节点需注意 你在使用RSS Trigger ( RSS触发 )节点时,如果RSS源一次更新20条文章的话,我们的工作流就要一次被执行20次,大大增加了服务器的负载,不利服务的稳定,如果更新条数过多的话很容易将服务器搞崩溃。 如果我们使用 RSS Read ( 阅读器 )节点 将最新的数20条文章一次读取,在后续进行批处理,就不存在这个问题。 我们只需要输入要获取哪个RSS的网址就可以了,节点输出数据结构和RSS输出结构是一致的。 ** 保留今日文章,过滤旧文章** 这时候我们会发现 RSS Read 输出的文章包括今日和过去一段时间内的文章,说明 RSS 输出的文章是会跨时间段的。也就是说,它不仅仅输出今天的文章,还会输出昨天的前天的文章,总之,是一段时间内的文章。 我们要的是将每天更新的新文章保存到 Edit Fields 节点,因此我们需要一个 Filter ( 过滤 ) 节点来过滤掉以前的文章。 Filter ( 过滤 ) 节点过滤掉昨天以前的文章 我们先上图看一下疯哥在 RSS Read 之后添加一层过滤器,专门根据日期过滤掉除了今日文章之外的所有文章。 Filter ( 过滤 ) 节点其实就是一个过滤条件设置节点,能选择各种过滤条类型,包括判断时间、判断数字大小、判断字符匹配等等条件。 官方是这样解释Filter ( 过滤 ) 节点的:根据条件过滤项目。如果数据满足条件,则 Filter 节点会将其传递到 Filter 节点输出中的下一个节点。如果项目不满足条件,则 Filter 节点会从其输出中忽略该数据。 n8n

在 Filter 节点中,我们可以通过 点击 Add Condition 按钮来添加过滤条件。我们可以看到,在这里我添加了一个过滤条件 “ is after ”,表示我们根据日期字段过滤只需要保留今日时间之后的所有文章,如下图: 不懂额同学看好,这里操作很简单,疯哥教你使用鼠标按住“puDate”字段名直接拖拽到fx框中就自动生成一段js代码,记住n8n中js都是包含在两个花括号中的就是这样的{{ js代码 }},如上图红色箭头所示。接着,我们选择过滤条件,n8n内置了丰富的过滤条件让我们选择,点击下拉框我们可以按照过滤的类别进行选择,如下图: 本例中,我们是要按照时间过滤,所以选择 Date&Time 类别,在二级菜单中选择“ is after ”项,“ Date&Time > is afte ”表示过滤“...在所选日期以后”。我们可以看到n8n还提供了过滤“...在所选日期以前”或者大于小于某个时间点等等,通常都能满足我们各种实际情况下的各种过滤需求。 数据类别 | 描述 | String | 代表对字符串内容进行各种过滤,二级菜单会有各种针对字符串的过滤条件。字符串数据类型支持以下比较: 1. 存在 2. 不存在 3. 为空 4. 不为空 5. 等于 6. 不等于 7. 包含 8. 不包含 9. 开始于 10. 不是以...开头 11. 结尾为 12. 并非结束于 13. 匹配正则表达式 14. 与正则表达式不匹配 | Number | 对数字类别的数据进行判断过滤,数字数据类型支持以下比较:1. 存在2. 不存在3. 为空4. 不为空5. 等于6. 不等于7. 大于8. 小于9. 大于或等于10. 小于或等于 | Date&Time | 对时间类别的数据进行判断过滤,日期数据类型支持以下比较:1. 存在2. 不存在3. 为空4. 不为空5. 等于6. 不等于7. 之后8. 之前9. 晚于或等于10. 早于或等于 | Boolean | 对“是或真(ture)”和“不是或假(false)”的布尔类别的数据进行判断过滤,布尔数据类型支持以下比较:1. 存在2. 不存在3. 为空4. 不为空5. 是真的6. 是错误的7. 等于8. 不等于 | Array | 对数组类别的数据进行判断过滤,数组数据类型支持以下比较:1. 存在2. 不存在3. 为空4. 不为空5. 包含6. 不包含7. 长度等于8. 长度不等于9. 长度大于10. 长度小于11. 长度大于或等于12. 长度小于或等于 | Object | 对一个对象数据进行判断过滤,对象数据类型支持以下比较: 1. 存在 2. 不存在 3. 为空 4. 不为空 |

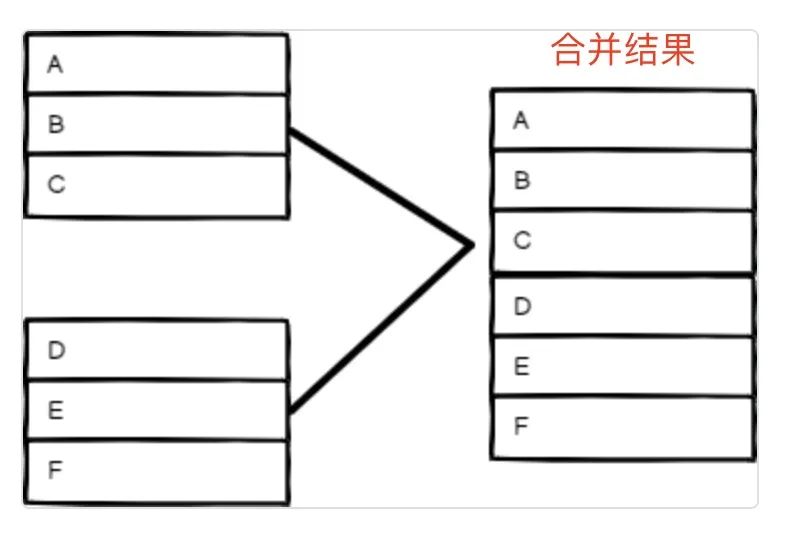

我们再看一下这句表达式 {{ $today }} 它代表今天的日期,会根据我们每次运行工作流的时间而变动。在n8n中,我们把文本框设置为“Expression”模式时,你可以使用 {{ ... }} 来插入表达式。与之对应的是“Fixed”模式。在 Fixed 模式下,文本框里的内容将被完全视为一段文本,不会当作表达式运行。 我们可以从输出看到,经过这个条件执行中,输出面板里丢弃了 7 条结果,保留了 23 条结果。证明我们此次运行时,RSS 原本里包含了 7 条昨天的新闻。 ** 合并多篇文章** 在本例中我们使用了4个 RSS Read ( 阅读器 )节点,每次执行AI自动化工作流时同时会从每 RSS Read 中获取多篇文章,算一下每次共有60篇左右的文章会被工作流处理,所以,后续工作流会对每篇文章进行处理,我们就需要先将多篇文章合并在一个虚拟表格中,然后使用Loop循环节点一一对每篇文章进行分批处理。 n8n为我们提供的合并节点是" Merge (合并)节点 ",简单说该节点作用是将上游输出的多条数据合并成一个。 Merge (合并)节点也很简单不复杂,没有多余的设置。我们先设置有多条输入项需要把它们合并,本案例中我们有 4个 RSS Read ( 阅读器 )节点,所以 ,“Number of Inputs”设置为4,如图: Merge (合并)节点会根据4种合并方式将输入的数据进行合并输出,这4种合并方式是: 合并方式 | 描述 | Append | 追加,简单说后面RSS输出的文章附加在前一个RSS文章后面,依此类推, 示意图:

该模式适用于要合并的两者数据字段完全一致的情况。 | Combine | 1. Matching Fields (匹配字段模式) 顾名思义两个不同字段的数据通过该模式进行合并,比如从第一个RSS获取文章的信息包含:标题、作者、文章内容三个字段。从第二个RSS获取文章的信息包含:标题、作者、日期三个字段,那么,合并输出的字段就是标题、作者、日期、文章内容。变成4个字段,你看懂了么?相同字段合并在一起,不同字段追加上。示意图: 2. Position (位置模式)根据项目的顺序进行组合。输入 1 中索引 0 处的项目与输入 2 中索引 0 处的项目合并,依此类推。示意图: 举例说明,如果有两个表格,每个表格的字段属性相同,就可以将两个相同字段进行合并,比如有个班级学生姓名的字段,表1包含1~3年级学生名字,表2包含4-6年级学生名字,合并之后,学生名字字段数据就是 1~3年级 + 4~6年级学生名字,你看懂了么?就是说,合并前每个表存放的都是部分数据,合并后就是完整数据。

3. All Possible Combinations (所有交叉组合模式)简单说将两个相同字段的列表按照多对多的组合合并在一起。官方解释:输出所有可能的项目组合,同时合并同名的字段。示意图: | SQL Query | 编写自定义 SQL 查询来合并数据,掌握SQL语言的同学会觉得非常简单,使用两张表互相关联的SQL例子来说明:SELECT * FROM input1 LEFT JOIN input2 ON input1.name = input2.ids | Choose Brancg | 基本很少用。 |

** 循环处理多篇文章** 我们通常要批量处理数据时都会构造一个循环流程来依次处理数据,这里的“批量”代表每次处理数据的条数,每次一条也可以每次多条,没错!n8n又为我们提供了内置循环节点 - Loop Over Items (循环遍历)节点 Loop Over Items (循环遍历)节点,有两个链接点,“loop”主要连接接下去要走的节点,“done”表示当节点执行完成时,它会合并所有处理后的数据并通过done输出返回。简单说就是当所有的批次执行完毕之后,数据被合并推送到 done 分叉,执行后续的循环外操作。 Loop Over Items (循环遍历)节点的“Batch Size”参数表示每次循环处理几条数据,这里 的批次就是我们说的循环,如果设置为5那么每次输出到下游节点的数据就是每次5条,我们下游的节点是 AI Agent,本例中疯哥设置的1,表示每次Deepseek分析一篇文章的标题和内容,如设置为5,表示每次Deepseek同时分析五篇文章的标题和内容,这样显然加大了工作流的负载,单次内容多过也会影响Deepseek的处理速度,而且,Deepseek每次对话最大token数大约4096个字符,超出的字符会被截掉。 我们通常在以下几个场景可以使用 Loop Over Items (循环遍历)节点: 1. 需要分批处理数据的情况,依次处理更加节省服务器资源,性能也会提高。 2. 在我们确定会导致节点发生错误的情况下我们希望在某一行运行错误的情况下,剩下流程行依然能继续运行。 3. 我们希望控制数据处理的频次,以保障第三方 API 可以正常运行。 在本例中,疯哥是希望用Deepseek分析总结一篇AI新闻后就自动给用户发送邮件,发送成功后循环处理下一篇新闻文章。并不需要一次处理多篇新闻文章。大家看一下本例中Loop Over Items (循环遍历)节点的执行范围截图: ** AI生成背景图** 本例中我们需要将AI输出的新闻配合背景图合成一张新闻海报,文章开头我们看到了工作流最后输出的海报图,选择调用阿里云“百炼大模型”平台的FLUX模型为我们文生图生成图片。 步骤2: 现在疯哥教大家如何调用阿里云FLUX大模型的API帮我生成图片,双击,HTTP Request 节点作为请求阿里云API的访问节点,我们点击 HTTP Request 节点看一下阿里云API调用的参数设置,如下图: 接着往下设置请求头主要的参数,将”API-Key“字符串作为“Authorization‘参数的值输入。 现在最核心的部分就是这里,因为调用API是POST方法,所以我们需要开启“Send Body”并在Body中设置json格式的请求参数和值,如下图: 提示词要写在这里,请参考上面的截图。疯哥将详细的参数设置放在下面的表格里,同学根据自己需要设置相关参数即可。 请求API参数说明: 参数 | 类型 | 默认值 | 说明 | model | |

| 指定用于对话的FLUX文生图模型名,目前支持传入 "flux-schnell" 和 "flux-dev"。 | prompt | |

| 用户当前输入的期望模型生成的文本信息。用户当前输入的期望模型生成的文本信息。支持中英文,中文不超过 500 个字符,英文不超过 500 个单词,超过部分会自动截断。 | size(可选) | | | 生成图像的分辨率,目前支持"512*1024, 768*512, 768*1024, 1024*576, 576*1024, 1024*1024"六种分辨率,默认为1024*1024像素。 | seed(可选) | |

| 图片生成时候的种子值,如果不提供,则算法自动用一个随机生成的数字作为种子。 | steps(可选) | |

| 图片生成的推理步数,如果不提供,则默认为30。 flux-schnell 模型官方默认 steps 为4,flux-dev 模型官方默认 steps 为50。 | guidance(可选) | | | 指导度量值,用于在图像生成过程中调整模型的创造性与文本指导的紧密度。较高的值会使得生成的图像更忠于文本提示,但可能减少多样性;较低的值则允许更多创造性,增加图像变化。默认值为3.5。 | offload(可选) | | | 一个布尔值,表示是否在采样过程中将部分计算密集型组件临时从GPU卸载到CPU,以减轻内存压力或提升效率。如果您的系统资源有限或希望加速采样过程,可以启用此选项,默认为False。 | add_sampling_metadata(可选) | | | 一个布尔值,决定是否在输出的图像文件中嵌入生成时使用的提示文本等元数据信息。这对于后续跟踪或分享生成设置非常有用,默认为True。 |

值得注意的是 “Size”参数的值表示生成图片的分辨率,512*1024适合手机屏幕尺寸。 步骤3:在n8n中处理阿里云API返回的结果。当调用阿里云FLUX的API后,模型生成图片都会经过三个阶段:“任务排队”、“处理中”和“生成完成”三个状态。所以,我们要请求API好几次知道APi返回结果状态是“SUCCESSED:任务执行成功”,这时候API还会返回给我们一个下载生成好的图片地址,我们将它下载到节点就可以了。 API返回参数说明 返回参数 | 类型 | 说明 | | | 200(HTTPStatus.OK)表示请求成功,否则表示请求失败,可以通过code获取错误码,通过message字段获取错误详细信息。 | | | 系统生成的标志本次调用的id。 | | | 表示请求失败,表示错误码,成功忽略。 | | | 失败,表示失败详细信息,成功忽略。 | | | 调用结果信息,对于千问模型,包含输出text。 | | | 异步任务id。 | | | 任务状态: SUCCESSED:任务执行成功 FAILED:任务执行失败 CANCELED:任务被取消 PENDING:任务排队中 SUSPENDED:任务挂起 RUNNING:任务处理中

| | | 生成结果,每个元素为生成图片的url。 | | | 任务结果信息,TOTAL期望生成数量,SUCCEEDED成功生成数量,FAILED失败数量。 | | | image_count用于计量的图片个数。 |

大家请看实际运行效果,通常调用API后返回的执行状态都是“ PENDING(任务排队中) ”,FLUX模型在处理生图是需要20秒钟左右时间的,所以,一开始的状态肯定是“ PENDING(任务排队中) ”或“ RUNNING(任务处理中) ”,等我们再次通过任务ID查询API执行状态时如果返回状态是“ SUCCESSED(任务执行成功) ”就代表图片生成完成了。我们看一下调用API后马上返回的结果截图: 看到返回结果中 " task_status (任务状态) " = "PENDING ( 任务排队中 )",还返回了“ task_id(任务ID)= " fd55eed2-4cc6-4d14-a38c-0d2daa606c77 ",后面我们需要使用任务ID插叙API当前执行的状态,了解FLUX大模型生成图片的进行到哪一步了。 所以,疯哥为了方便就干脆等待30秒后再查询API看任务状态值,如果任务状态是 SUCCESSED ( 任务执行完成 )那么下一步就直接下载生成好的图片。 如果一定要根据API返回的任务状态值来判断是否执行下载图片操作的话,那么我们就要用到“ Switch (判断) ”节点,根据API返回任务状态不同的值判断执行那个分支流程。比如,任务状态不是SUCCESSED ( 任务执行完成 )就执行等待节点,或一段时间才尝试。如果返回的是执行失败的状态那么我们就要走处理错误的分支流程。 设置“ Switch (判断) ”节点非常简单,只要将API返回状态的值作为判断就行,工作流将根据匹配状态值判断后续走哪条分支流程。其实本例中,疯哥并没有将分支搭建出来,就当然做给各位同学的回家作业,看看你是否能正确搭建每个后续分支流程。 步骤4:获取图片URL,阿里云FLUX文生图API一旦执行完成会返回图片URL供我们下载。 我们看到“HTTP Request”节点输出结果信息中,task_status = SUCCESSED ( 任务执行完成 ),这时候URL我们已经可以获取到了。接下去,我们还是继续使用“HTTP Request”节点根据URL下载图片文件 步骤5:上一步骤我们获取到了URL,现在可以根据URL下载图片文件了。 通过“HTTP Request”节点可以轻松下载图片,不仅是图片只要是二进制的文件都可以通过“HTTP Request”节点下载,看一下“HTTP Request”节点设置。 直接可以在输出窗体中浏览图片。 步骤6:图文合并,上面我们成功获得了FLUX生成的海报图片,现在我们将新闻内容放到图片上相应的位置合并为一张新闻海报,疯哥教大家使用一个新n8n节点“ Edit Image ( 图像编辑)节点 ”来解决图文合并的问题。 n8n提供的图像编辑节点非常强大,我们一起来看一下它都包含哪些功能:

本例中我们将使用到11项,在图片上添加文字。 ** 文生图大模型FLUX介绍** 疯哥顺道科普一下FLUX模型,要说FLUX模型,可能很多小伙伴都没听说过。这并不奇怪。FLUX可以说是当今最好的文本生成图大模型,没有之一。FLUX是由Black Forest Labs(黑森林实验室)推出的一款最新的文本生成图大模型。而Black Forest Labs是在2014年8月1日宣布启动的。 使用过文本生成图片的同学想必都听说过“Stable Diffusion”吧,最有名的开源生图大模型,而Black Forest Labs就是由Stable Diffusion原班人马创立的新公司,专注于开发先进的生成式深度学习模型,并致力于建立新的行业标准。该公司由Robin Rombach领导,他是Stable Diffusion的作者之一。Black Forest Labs的核心使命是通过开发强大且易于访问的生成式AI工具,使得高质量的生成式AI技术普及化。Black Forest Labs认为开放的访问权限和广泛的研究社区合作对AI技术的负责任发展至关重要。这一理念体现在他们发布的模型中,这些开源模型供非商业用途使用,同时他们也提供适用于商业应用的更强大版本。 FLUX模型全名为FLUX.1,是Black Forest Labs最近推出的文本生成图像的AI模型。 FLUX.1模型包含三个版本:FLUX.1 [pro]、FLUX.1 [dev]和FLUX.1 [schnell],分别针对不同的使用场景和需求。其中,FLUX.1 [pro]是闭源模型,提供最佳性能,而FLUX.1 [dev]和[schnell]则是开源模型,[dev] 版本不可商用,[schnell]版本则专为本地开发和个人使用设计,具有最快的生成速度和最小的内存占用。 ** 根据Black Forest Labs官方的测试对比图,FLUX.1 [pro]和[dev]版本在多方面超越了市场上的主流文生图模型,包括Midjourney v6.0、DALL·E 3 (HD)和SD3-Ultra。这些方面包括视觉质量、对提示词的精准遵循、尺寸和比例的多样性、排版能力以及输出的多样性。 ** 同时阿里云上线了 FLUX.1 [dev] 模型是一款面向非商业应用的开源权重、精炼模型。 FLUX.1 [dev] 在保持了与 FLUX 专业版相近的图像质量和指令遵循能力的同时,具备更高的运行效率。相较于同尺寸的标准模型,它在资源利用上更为高效。除了为 FLUX 系列的官方模型与基于 FLUX 架构的开源社区模型提供服务化支撑外,阿里云还针对 FLUX 文生图模型实施了中文 Prompt 的适应性优化。此番调整确保了模型能够深刻理解并精准响应中文指令,进而生成与英文 Prompt 同等质量的图像成果。 最新的FLUX模型不仅在文生图领域领先而且在文生视频、图转视频领域也做的非常好,不妨看一下他的官方网站上的案例:

** ** 海报通过邮箱附件发送给用户

我们来到最后一步就是将新闻和海报发送到用户的邮箱,这里用户可以是你公司的注册用户,也可以是活动收集来的用户邮箱等等。总之,我们需要将订阅邮箱或者推送一些活动营销类邮件给用户的话。现在,疯哥教大家将合并后的海报作为附件通过邮件形式发送到用户邮箱。 "Send Mails"节点在上篇就已经讲解过如何使用"Send Mails"节点发送普通邮件,本篇就带大家了解如何发送带附件的邮件,附件可以是任何形式的对象,比如图片、文件、压缩包等等。废话不多说,我们先上图: 重点看上图红色区域,从上游节点获取到海报之后,我们只需要点击“Add Option”按钮添加一个“Attachments”参数,自定义一个附件名称就可以了。 由于时间和篇幅的原因本章就写到这里,有疏漏和不足的地方欢迎大家找我交流指正,希望你能喜欢我的原创内容并收藏和分享它,能让更多人都来学习应用AI自动化工具,再次感谢,晚安 (2025年3月10日晚) ** 我叫“疯哥智造”** 本章最后疯哥做个简短说明,疯哥的“微信视频号”和“抖音号”都叫 疯哥智造 ,“ 智造 ”一词代表现在一直到未来2到3年疯哥都将打造各种贴合实战场景的AI自动化应用去帮助企业和个人实现AI转型,并为需要企业知识库和AI智能体的同学提供服务。为了“让人类只负责做梦,AI负责实现”这个目标尽早实现,就跟着疯哥一起努力学习、掌握和应用AI。 结语:我们要在实际工作和业务中寻找可以被AI替代的场景,在n8n中可以随时方便的调用各种多模态的AI,掌握AI自动化是未来必备技能。 本章节,在上章节基础上继续升级本款工作流,大家学到了如何在n8n中使用Flux模型为我们生成图片,利用图片作为背景结合获取的新闻内容自动生成运营海报。最后,我们还学到了如何将我们的海报推送到微信群,实现了全自动化运营工作流。 n8n以其开源、灵活、可定制的特性,迅速成为AI自动化领域的超级工具。无论是希望提升个人工作效率,还是企业希望AI自动化转型实现全自动化业务流程,n8n都可以提供强大的技术支持。 #n8n #AI自动化 #AI Agent #AI智能体 #AI自动化工作流 #AI教程

2025年AI自动化爆炸式提升企业效率的时代已经来了! 👉 关注疯哥公号 ➡️ @“ 疯哥AI ” ,手把手教你用AI轻松构建自动化工作流。

有任何疑问请留言!你的问题可能是别人的灵感,欢迎在评论区畅所欲言~

下期预告《第八章:(知识库基础篇) 3天搭建企业级AI知识库!n8n零代码自动化实战指南》

|